英伟达AI服务器性能飞跃!MoE模型突破10倍提升

创始人

2025-12-04 11:29:57

0次

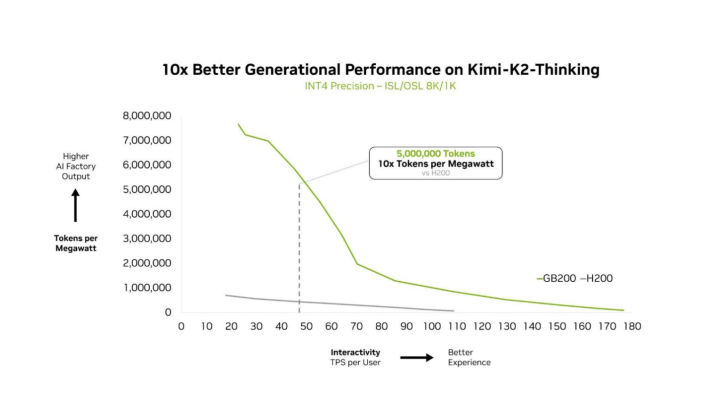

12月3日,科技媒体Wccftech报道,英伟达在混合专家(MoE)模型上取得了重大性能突破。GB200NVL72AI服务器在基于开源大语言模型的测试中,相比上一代HopperHGX200性能提升了10倍。混合专家模型是一种高效的AI大模型架构,通过激活一小部分最相关的参数子集来解决问题,显著降低计算成本并提高处理速度。

英伟达采用“协同设计”策略,整合了GB200的72芯片配置、30TB快速共享内存、第二代Transformer引擎和第五代NVLink高速互联技术,实现了专家并行计算的新水平。此外,英伟达还实施了全栈优化措施,如NVIDIADynamo框架和NVFP4数据格式,进一步提升MoE模型的推理性能。

此次性能突破对英伟达及其合作伙伴具有重要意义,成功克服了MoE模型扩展时的计算瓶颈,满足了AI算力需求的增长,并巩固了英伟达在AI服务器市场的领先地位。

相关内容

热门资讯

“30秒手搓游戏!蚂蚁AI助手...

12月4日,蚂蚁集团宣布其AI助手灵光进行了升级,新增了闪游戏功能。这一功能允许用户通过简单的自然语...

【光明论坛】推动资源环境要素高...

作者:吴剑锋(福建师范大学党委副书记、副研究员)绿色发展是中国式现代化的鲜明底色。党的二十届四中全会...

沃野绘新景 农田变良田

天山网-新疆日报记者 魏永贵党的二十届四中全会提出,高质量推进高标准农田建设,加强黑土地保护和盐碱地...

以下是一些改写“回应民生关切”...

回应民生关切是政府工作的重要使命。通过加强政策调研,精准把握民众需求,制定切实可行的举措。在教育方面...

英伟达AI服务器性能飞跃!Mo...

12月3日,科技媒体Wccftech报道,英伟达在混合专家(MoE)模型上取得了重大性能突破。GB2...

中国新能源汽车满意度攀升!自主...

12月4日,中国质量协会在北京发布了2025年中国新能源汽车行业用户满意度指数测评结果。测评显示,2...

法拉第未来FXSuperOne...

12月4日,法拉第未来宣布首批FXSuperOne的整套零部件已顺利抵达美国长滩港,并完成清关。这些...

中国数据集突破500PB!AI...

12月4日,我国高质量数据集建设取得显著进展。据最新数据显示,截至三季度末,我国已建成高质量数据集总...

中国新能源车全球占比飙升至68...

今日,乘联分会秘书长崔东树发文指出,2025年1-10月全球新能源乘用车销量达到1736万台,同比增...