AI智能体自主运行时长翻倍,用户信任度提升显著

创始人

2026-02-22 16:46:55

0次

Anthropic于2月18日发布了首份AI智能体行为实测报告,通过对ClaudeCode及公共API上的数百万次人机交互进行隐私保护分析,揭示了AI智能体在实际部署中的自主程度、风险分布与监督模式。研究发现,ClaudeCode的自主工作时长显著增加,其单次连续自主运行的最长时长在三个月内几乎翻倍。在2025年10月至2026年1月期间,其“turnduration”第99.9百分位的运行时长从不足25分钟上升至超过45分钟,而中位数时长维持在约45秒,波动有限。

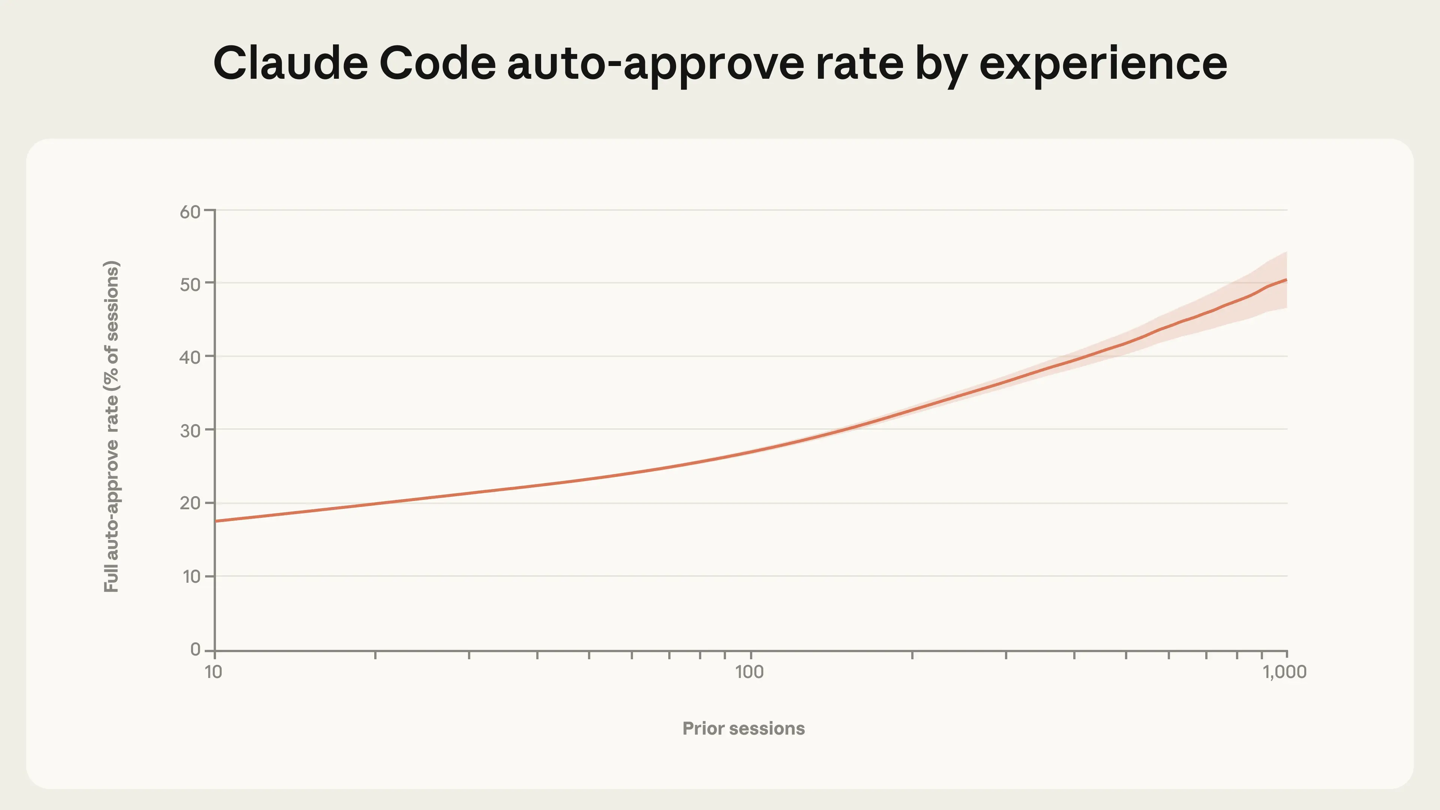

研究还指出,ClaudeCode在处理最具挑战性任务时的成功率自2025年8月至12月间翻倍增长,平均每个会话中的人工干预次数从5.4次下降至3.3次。这表明模型在实际部署中的“可用自主空间”可能高于当前用户赋予的水平。经验丰富的用户更倾向于采用“全自动模式”,而新用户仅在约20%的会话中启用“全自动模式”。Anthropic在公开API数据中也观察到类似情况,针对低复杂度任务约87%的工具调用存在某种形式的人工参与,而在高复杂度任务中,这一比例降至67%。

在风险领域,研究显示,大多数通过公共API执行的操作风险较低且可逆。软件工程占所有智能体活动的近50%,但医疗、金融和网络安全等领域也已出现新兴应用。尽管高风险操作目前占比极小,但一旦出错,其后果可能相当严重。Anthropic基于这些发现,向模型开发者、产品开发者和政策制定者提出建议,包括投资于部署后监控基础设施、训练模型识别自身不确定性、设计支持用户有效监督的交互工具,并避免过早强制规定具体的交互模式。

相关内容

热门资讯

春节返程高峰来袭:高速堵哭,铁...

2月22日,春节假期接近尾声,全国公路迎来返程高峰。据预测,高速公路车流量将超过7100万辆次,成为...

特稿|骁行万里 四海同春——世...

新华社北京2月22日电(记者宋盈 席玥)马踏福至,岁启新篇。从冰雪覆盖的芬兰首都赫尔辛基,到夏花绽放...

台胞在大陆怎么过年?跟着记者沉...

在大陆的台胞怎么过年?两岸有哪些共通的年俗?人民日报记者前往福州、苏州参加了两场特别的团圆宴。让我们...

比亚迪海狮06DM-i升级:纯...

近日,比亚迪海狮06DM-i迎来新版本上市,CLTC纯电续航提升至220公里。此次升级包括电机功率增...

全球媒体聚焦 | 外媒:春节文...

尼日利亚《蓝图报》2月21日刊发题为《中国春节在世界舞台上大放异彩》的文章。文章说,随着中国春节的到...

我们的节日·春节丨非遗焕彩贺新...

2月20日,鼓手们在乌鲁木齐大巴扎疆来城二期表演国家级非遗开封盘鼓。 天山网-新疆日报记者约提克尔·...

在广州新春灯会,看见“广货”穿...

这个春节,2026广州新春灯会化作一幅跨越千年的“时空画卷”,在璀璨灯火中解码“广货”行销天下的爆款...

英伟达Rubin GPU或采用...

2月22日,据韩媒ETNEWS报道,英伟达正在考虑对其Rubin AI GPU的HBM内存采用Dua...

AI智能体自主运行时长翻倍,用...

Anthropic于2月18日发布了首份AI智能体行为实测报告,通过对ClaudeCode及公共AP...

1月中国动力电池产量增25%,...

今日,乘联分会秘书长崔东树发文指出,我国1月动力电池及其他电池产量合计为168GWh,同比增长25%...