蚂蚁集团发布全模态大模型Ming-Flash-Omni2.0 引领多模态技术新突破

创始人

2026-02-11 12:04:58

0次

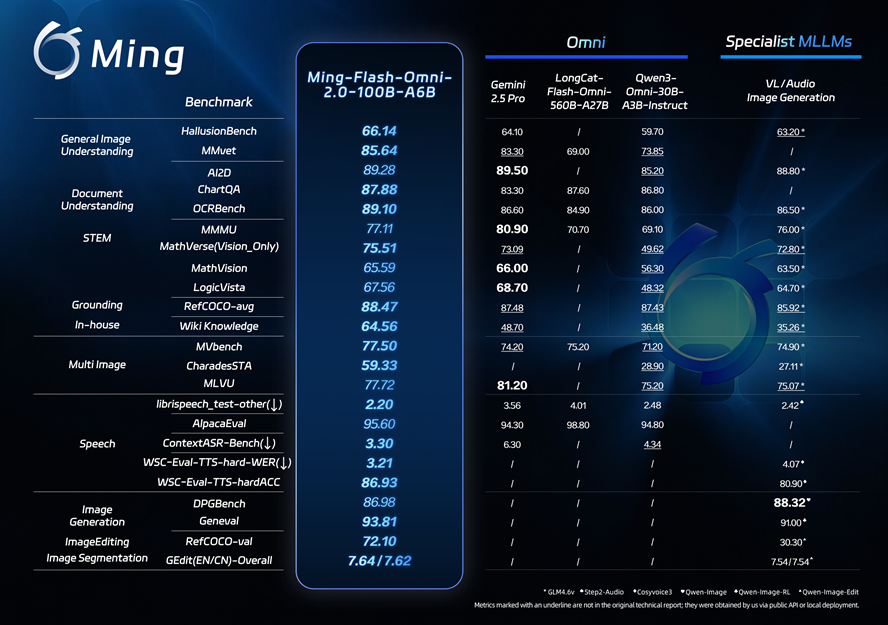

2月11日,蚂蚁集团宣布开源发布全模态大模型Ming-Flash-Omni2.0,该模型在视觉语言理解、语音可控生成、图像生成与编辑等多个领域表现出色。Ming-Flash-Omni2.0是业界首个全场景音频统一生成模型,能够在同一音轨中同时生成语音、环境音效与音乐,用户可以通过自然语言指令精细控制音色、语速、语调、音量、情绪与方言等参数。模型在推理阶段实现了3.1Hz的极低推理帧率,支持分钟级长音频的实时高保真生成,保持了业界领先的推理效率与成本控制。

Ming-Flash-Omni2.0基于Ling-2.0架构(MoE,100B-A6B)训练,全面优化了“看得更准、听得更细、生成更稳”三大目标。在视觉方面,模型融合了亿级细粒度数据与难例训练策略,显著提升了对复杂对象的识别能力;音频方面,实现了语音、音效、音乐同轨生成,并支持自然语言精细控制;图像方面,增强了复杂编辑的稳定性,支持光影调整、场景替换、人物姿态优化及一键修图等功能。百灵模型负责人周俊表示,全模态技术的关键在于通过统一架构实现多模态能力的深度融合与高效调用,开源后,开发者可以基于同一套框架复用视觉、语音与生成能力,降低多模型串联的复杂度与成本。

Ming-Flash-Omni2.0的模型权重、推理代码已在HuggingFace等开源社区发布,用户也可通过蚂蚁百灵官方平台LingStudio在线体验与调用。

相关内容

热门资讯

科大讯飞星火X2发布:国产算力...

今日,科大讯飞宣布推出基于全国产算力训练的星火X2大模型,标志着公司在人工智能领域的又一重要进展。星...

以更开放的姿态为全球发展带来广...

开放是中国基于发展需要作出的战略抉择,也是推动经济全球化、造福世界各国人民的实际行动。党的二十届四中...

小鹏汇天陆地航母零下35℃极限...

今日,小鹏汇天飞行汽车官方公众号宣布,其陆地航母飞行汽车在2026年1月成功完成了第三次冬测,顺利通...

民生暖、实干兴!亚太携手、共赴...

中国智慧和中国方案,不仅有“深而广”的战略布局,更有“小而美”的民生温度。从陆到海,从铁路到港口,中...

金观平:统筹兼顾推动城市建设绿...

城市高质量发展,离不开基础设施与时俱进,也需要人与自然和谐共生。我国幅员辽阔,不同地区的资源禀赋与发...

小米SU7/Ultra/YU7...

2月11日,第三方“数字旮旯”开发的小米SU7/Ultra/YU7系列车型辅助智驾小蓝灯配件在京东正...

“问界M7升级后遇违停,自动驾...

近日,华为ADS4.1辅助驾驶系统在实际应用中展现出了卓越的能力。一位老款问界M7车主在园区内遇到违...

中国智造机器人联合国展才艺,黄...

2月9日,智元机器人队伍在联合国“骏启新程”新春庆祝活动中展示了中国智造的魅力。活动中,远征A2机器...

奥迪2027款A6e-tron...

近日,奥迪官方发布了2027款A6e-tron与Q6e-tron家族官图,重点对内饰操作配置进行调整...

南宁清厢快速路电动汽车追尾起火...

昨日下午,南宁市清厢快速路靠近南宁火车站匝道附近发生一起交通事故。一辆电动汽车与一辆SUV发生追尾,...