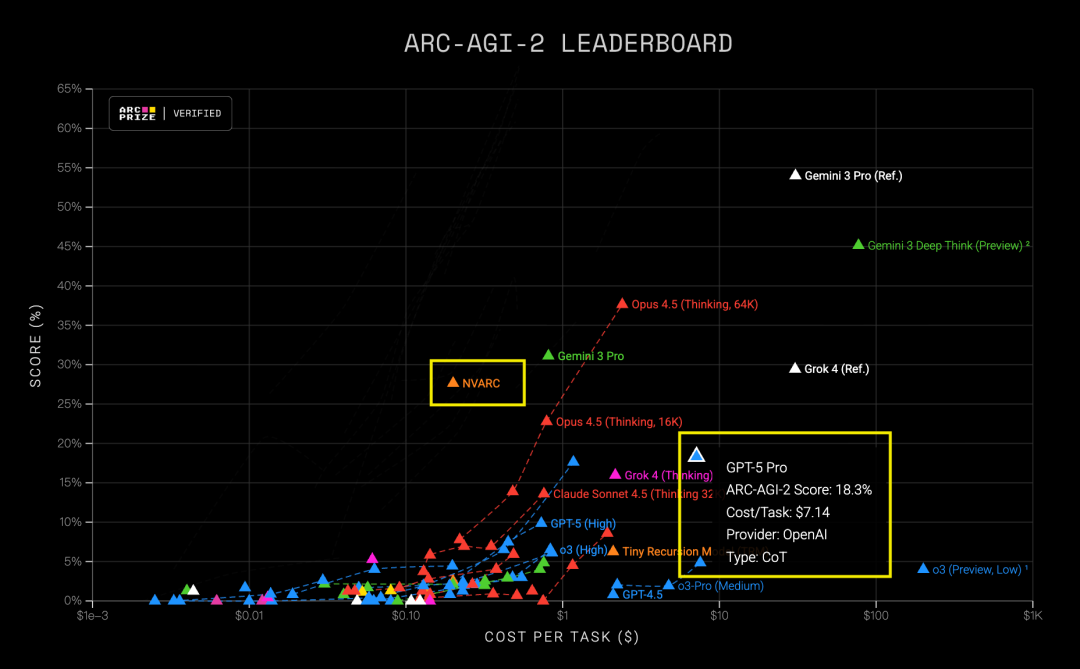

英伟达小模型ARC-AGI2夺冠,成本仅GPT-5Pro的1/36

创始人

2025-12-08 16:10:58

0次

近日,英伟达的ARC-AGI2竞赛中,NVARC小模型以27.64%的成绩超越GPT-5Pro的18.3%,成为榜首。NVARC的每任务成本仅为20美分,远低于GPT-5Pro的超过7美元。NVARC的成功在于其零预训练深度学习方法,避免了预训练模型的领域偏见和数据依赖问题。

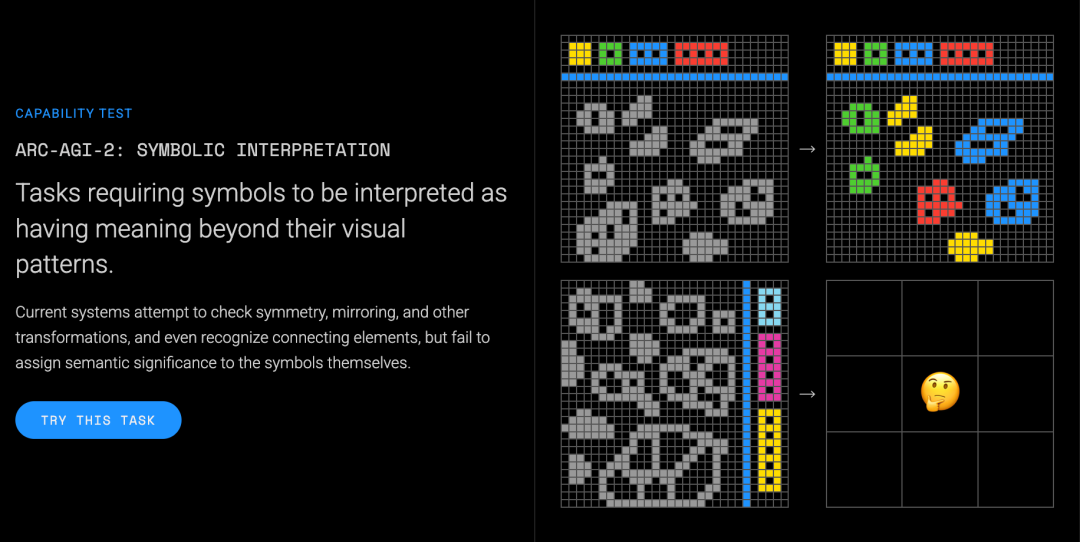

NVARC团队采用了改进版ARChitects方法,选用小参数模型Qwen3-4B,通过对话式模板简化谜题理解。训练时借助NeMoRL框架和Megatron后端进行监督微调。关键一步在于测试时微调(TTFT),针对ARC-AGI-2每个任务都是全新规则的特点,NVARC引入了LoRA微调技术,对每个问题都进行微调,让模型快速适应。同时,对ARChitects方法的改进在于解码阶段DFS算法做了批处理优化,修复结果非确定性问题。

NVARC团队还应用了“少即是多”的TRM方法,尝试与Qwen3-4B集成补充分数,虽有提升但未大幅优化。这一成果表明,在特定领域任务中,经过针对性优化的小模型性能并不逊色于全面发力的超级大模型。将正确的方法用在正确的地方,小模型也能实现更大的价值。

相关内容

热门资讯

大众EA211增程器下线,ID...

3月4日,上汽大众宣布其首台EA211“黄金增程器”正式下线,并将应用于ID.ERA9X车型。该车型...

比亚迪刀片电池+闪充技术亮相,...

3月5日,比亚迪将在深圳大运中心体育馆举行第二代刀片电池暨闪充技术发布会。此次发布会备受瞩目,因为比...

智元机器人灵渠OSAlpha版...

智元机器人今日宣布,其自研机器人操作系统“智元灵渠OS”的Alpha版本已正式开源发布。这一开源计划...

鸿蒙座舱天籁3月5日迎首次OT...

3月4日,鸿蒙智行技术焕新发布会正式官宣,将于14:30举行,主题为“万象更新,驭见未来”。东风日产...

仰望U7首搭比亚迪第二代刀片电...

今日,仰望汽车宣布其2026款仰望U7将首次搭载比亚迪第二代刀片电池,实现了1006公里的超长纯电续...

华为激光雷达加持,阿维塔06T...

3月4日,阿维塔汽车官方宣布,全新车型阿维塔06T计划在五一前后上市。该车型定位为“智美全场景运动轿...

全球瞭望|西班牙媒体:美以对伊...

新华社巴塞罗那3月3日电(记者孟鼎博)西班牙《国家报》近日刊登题为《特朗普与内塔尼亚胡在伊朗打开“潘...

2026全国两会第1眼特别策划...

重庆广电-第1眼TV进一步形成大保护、大开放、高质量发展新格局,提升区域整体实力和可持续发展能力,在...

粤北一地速降14.5℃!今起广...

最近广东的天气起起伏伏,前段时间还热到穿短袖,这就降温了。近日,广州麓湖公园花开烂漫,行人走过红花绿...