宇树开源UnifoLM-VLA-0大模型,12类复杂操作任务一网打尽

创始人

2026-01-29 21:11:08

0次

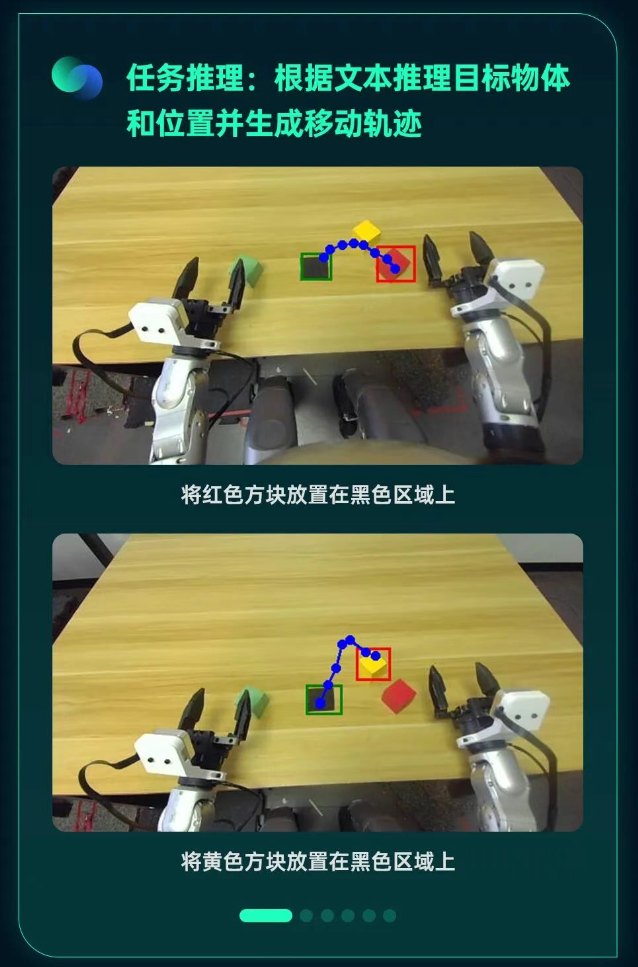

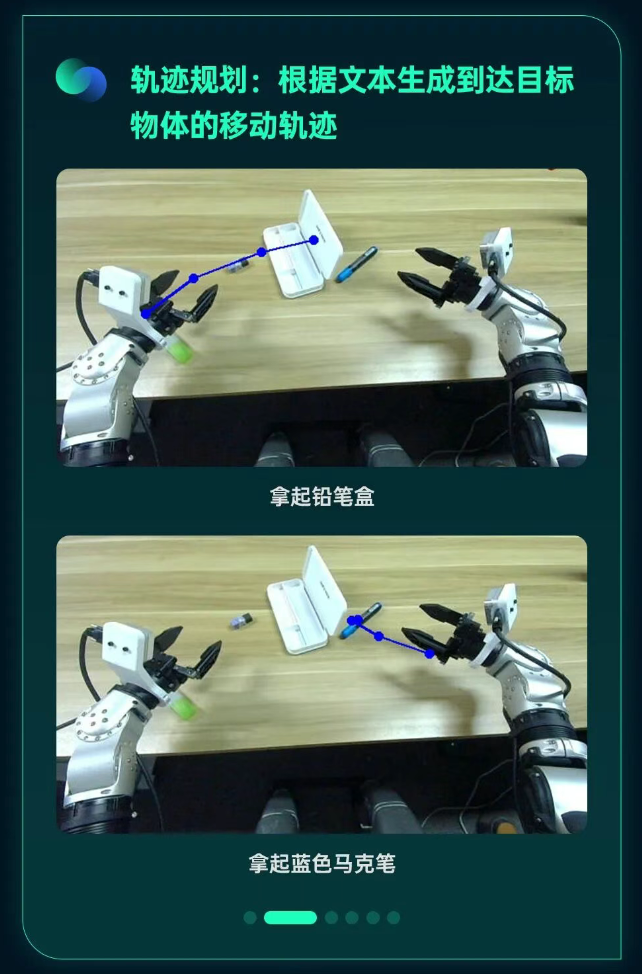

今日,宇树科技宣布开源UnifoLM-VLA-0大模型,这是UnifoLM系列中面向通用人形机器人操作的视觉-语言-动作(VLA)模型。该模型通过在机器人操作数据上的预训练,实现了从图文理解到具备物理常识的“具身大脑”的进化。它通过深度融合文本指令与2D/3D空间细节,增强了空间感知能力,并构建了全链路动力学预测数据,提升了任务泛化性。在真机验证中,该模型仅需单一策略即可高质量完成12类复杂的操作任务。

基于Qwen2.5-VL-7B开源模型,宇树构建了覆盖机器人与通用场景的多任务数据集,并开展持续预训练。数据集包括2D检测与分割、任务层级分解、3D目标检测等多维数据,有效提升了模型对几何空间与语义逻辑的对齐能力。针对操作类任务,宇树对开源数据集进行了系统化清洗,利用约340小时的真机数据进行离散动作的预测训练。模型集成了动作分块预测及动力学约束,实现对动作序列的统一建模,支持长时序动作规划与决策。

在UnifoLM-VLM-0模型的基础上,宇树集成了动作预测头(ActionHead),构建出UnifoLM-VLA-0。经过仿真环境与真机实验的多任务训练验证,该模型展现了单模型处理多任务的通用能力,在LIBERO仿真基准测试中取得了接近最优的性能。在宇树G1人形机器人平台上,基于高质量真机数据集对UnifoLM-VLA-0进行单一策略网络的统一端到端训练,实验结果表明,该模型能够稳定完成全部12项任务,在外部扰动条件下保持良好的执行鲁棒性与抗干扰能力。

相关内容

热门资讯

自动驾驶新突破!文远知行WeR...

1月28日,自动驾驶科技公司文远知行WeRide发布了自研的通用仿真模型WeRideGENESIS,...

男子尾随单身女性进入其房间,展...

男子赵某尾随单身女性进入出租房提出“借钱”还录制了分期还款的视频女子无奈通过网络贷款转账2.8万元待...

2026中国(南沙)幸福产业创...

文/羊城晚报全媒体记者 江皓轩图/主办方提供2026年1月28日,以“融合创新,赋能未来”为主题的2...

社评:套上马甲也无法改变高市涉...

日本首相高市早苗近日在一档电视节目中再度发表涉台言论,宣称“如果台海发生危机,美日可能采取联合行动撤...

全球媒体聚焦丨美媒:中国的能源...

美国彭博社网站28日发表题为《中国凭借能源建设热潮获得竞争优势》的文章。美国彭博社网站文章报道截图文...

2025年江苏GDP首破14万...

江苏省统计局今天官宣,2025江苏GDP首破14万亿,站上新台阶。14万亿是什么概念?戳视频一起了解...

赛事落幕,执法不歇!广州天河以...

垃圾分类执法,不因重大赛事的结束而降低标准。记者1月29日从广州市天河区城市管理和综合执法局获悉,天...

特斯拉2025年营收首降3%,...

2025年,特斯拉公司遭遇了自成立来首次营收下滑,总营收为948.3亿美元,同比下降3%。同时,公司...

宇树开源UnifoLM-VLA...

今日,宇树科技宣布开源UnifoLM-VLA-0大模型,这是UnifoLM系列中面向通用人形机器人操...

宾利欧陆GTS双门轿跑发布:V...

近日,宾利汽车公司发布了新款欧陆GTS双门轿跑和欧陆GTCS敞篷车,这两款新车型定位于入门版GT/G...