蚂蚁技术研究院发布100B参数扩散语言模型LLaDA2.0,性能超越自回归模型

创始人

2025-12-12 16:11:58

0次

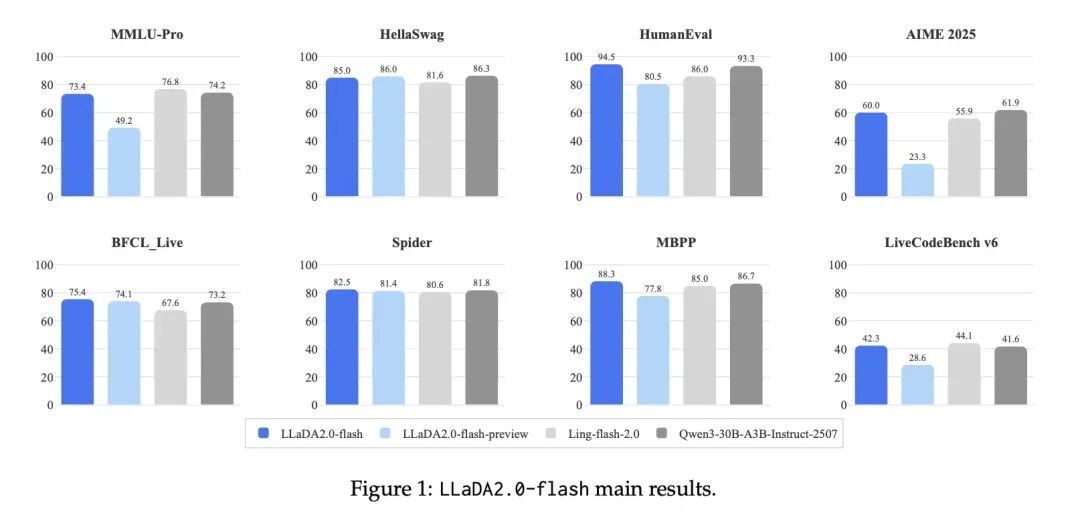

12月12日,蚂蚁技术研究院宣布推出LLaDA2.0系列离散扩散大语言模型(dLLM),并公开了背后的技术报告。LLaDA2.0包含16B(mini)和100B(flash)两个版本,将Diffusion模型的参数规模首次扩展到了100B量级。该模型不仅打破了扩散模型难以扩展的固有印象,更在代码、数学和智能体任务上展现出了超越同级自回归(AR)模型的性能。

LLaDA2.0通过创新的Warmup-Stable-Decay(WSD)持续预训练策略,能够无缝继承现有AR模型的知识,避免了从头训练的高昂成本。结合置信度感知并行训练(CAP)和扩散模型版DPO,LLaDA2.0在保证生成质量的同时,利用扩散模型的并行解码优势,实现了相比AR模型2.1倍的推理加速。蚂蚁技术研究院在多个维度对模型进行了评估,结果显示LLaDA2.0在结构化生成任务(如代码)上具有显著优势,并在其他领域与开源AR模型持平。

LLaDA2.0的模型权重(16B/100B)及相关训练代码已在Huggingface开源。

相关内容

热门资讯

检察长警告:微软AI聊天机器人...

12月11日,全美检察长协会向微软等大型科技企业发出警告,指出AI聊天机器人可能违反美国州法律,并要...

福特智趣烈马正式下线,预售22...

12月11日,福特智趣烈马在江铃汽车富山智能制造基地正式下线,标志着该基地2025年度第20万辆整车...

新闻1+1丨如何定调2026?...

工作会议2025年12月10日至11日在北京举行。会议指出,明年经济工作在政策取向上,要坚持稳中求进...

十年十项!这些中国项目列入人类...

新华社新德里12月11日电 正在印度新德里举行的联合国教科文组织保护非物质文化遗产政府间委员会第20...

主播说联播丨做好明年经济工作,...

中央经济工作会议12月10日至11日在北京举行。习近平总书记在重要讲话中总结2025年经济工作,分析...

拓展副业+生态治理 南木林县土...

中国西藏网讯 产业兴旺,青稞麦浪翻涌致富新篇;民生提质,柏油坦途连通幸福家园。绿意绵延间,西藏日喀则...

全球媒体聚焦 | 外媒:中国正...

2025年12月10日至11日,中央经济工作会议在北京召开,为2026年中国经济工作指明了方向。多家...

攀高逐“新” “质”领未来!智...

看潮州智能卫浴产业,藏着三个“看不见”。踏入车间,看不见传统陶瓷制造的粗放痕迹,5G智能生产线将陶瓷...

佛山一地现“鸟屎雨”!当地生态...

佛山顺德南国西路与新裕大道交叉口一带的居民,连续两个月遭遇特殊的“困扰”:每日傍晚,上万只燕子在此聚...

佛山一地现“鸟屎雨”!当地生态...

佛山顺德南国西路与新裕大道交叉口一带的居民,连续两个月遭遇特殊的“困扰”:每日傍晚,上万只燕子在此聚...