美团开源6B参数图像生成模型,文生图与编辑能力惊艳提升!

创始人

2025-12-08 10:29:57

0次

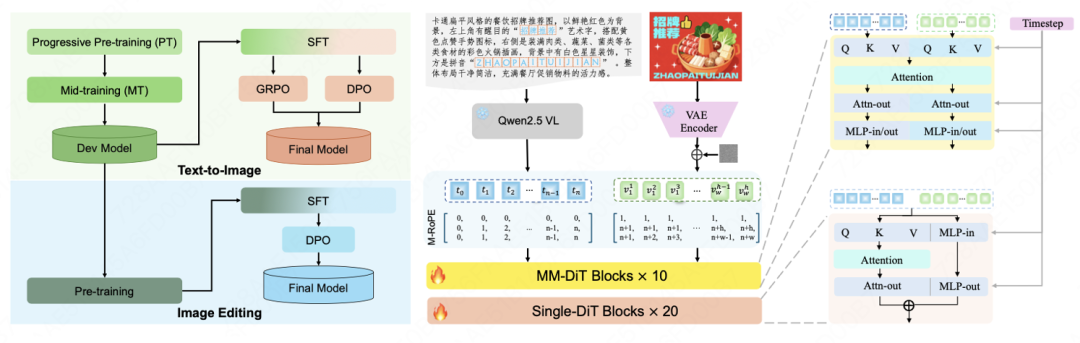

今日,美团LongCat团队宣布正式发布并开源了图像生成模型LongCat-Image。该模型以6B参数规模,在文生图和图像编辑的核心能力上接近更大尺寸模型的效果。LongCat-Image采用文生图与图像编辑同源的架构设计,并结合渐进式学习策略,实现了指令遵循精准度、生图质量与文字渲染能力的高效协同提升,尤其在单图编辑的可控性和文字生成的汉字覆盖度方面表现突出。

LongCat-Image在图像编辑领域的多个重要基准测试中达到开源SOTA水平,其性能突破的背后是一套紧密协同的训练范式和数据策略。模型基于文生图Mid-training阶段模型进行初始化,并采用指令编辑与文生图多任务联合学习机制,深化对复杂多样化指令的理解。此外,通过预训练阶段的多源数据及指令改写策略,以及SFT阶段引入人工精标数据,实现了指令遵循精准度、泛化性和编辑前后视觉一致性的共同提升。

针对中文文本渲染的行业痛点,LongCat-Image通过课程学习策略提升字符覆盖度和渲染精准度。预训练阶段基于千万量级合成数据学习字形,覆盖通用规范汉字表的8105个汉字;SFT阶段引入真实世界文本图像数据,提升在字体、排版布局上的泛化能力;RL阶段融入OCR与美学双奖励模型,进一步提升文本准确性与背景融合自然度。通过对prompt中指定渲染的文本采用字符级编码,大幅降低模型记忆负担,实现文字生成学习效率的跨越式提升。

相关内容

热门资讯

2026年广佛全域同城化党政联...

文/羊城晚报全媒体记者 罗仕 通讯员 史伟宗3月10日,2026年广佛全域同城化党政联席会议在穗召开...

中朝国际旅客列车3月12日起双...

自2026年3月12日起,中国北京、丹东至朝鲜平壤间双向开行国际旅客列车,进一步促进中朝两国人员往来...

全国人大代表、敦煌研究院保护研...

文/羊城晚报全媒体记者 梁善茵 何文涛 王莉图/羊城晚报全媒体记者 曾育文在2026年全国两会上,全...

视频丨长三角高效协同 助推“人...

今年的政府工作报告提出,支持京津冀、长三角、粤港澳大湾区打造世界级城市群。加强重点城市群协调联动,健...

伊朗称逮捕30名为美以从事间谍...

当地时间10日,伊朗情报部门表示,过去几天,伊朗情报部门人员查明并逮捕了30名为美国和以色列从事间谍...

物流配送、城市管理…“广州造”...

在广州开发区一间巨型微波暗室里,密集排列的蓝色吸波尖锥正模拟着太空电磁环境。一批将装备于卫星的相控阵...

两会粤视点③|一体推进教育科技...

编者按:春意渐浓,万象更新,2026年全国两会如约而至。今年是“十五五”开局之年,全国两会意义特殊、...

专访武汉大学法学院院长秦天宝:...

生态环境法典草案提请十四届全国人大四次会议审议,中国第二部法典正呼之欲出。如何理解这部法典的意义?编...

广东第二批区域植物园和乡土植物...

近日,广东省林业局正式公布第二批区域植物园和乡土植物园名单,将广州云萝植物园等16家迁地保护机构纳入...

新华视点丨向新向绿领航 探索传...

■一块钢板 见证日照钢铁产业绿色转型在山东日照,2000亿元级的钢铁产业正加速向产业价值链高端攀升,...