英伟达TiDAR技术:AI文本生成速度提升5倍!

创始人

2025-12-02 15:30:55

0次

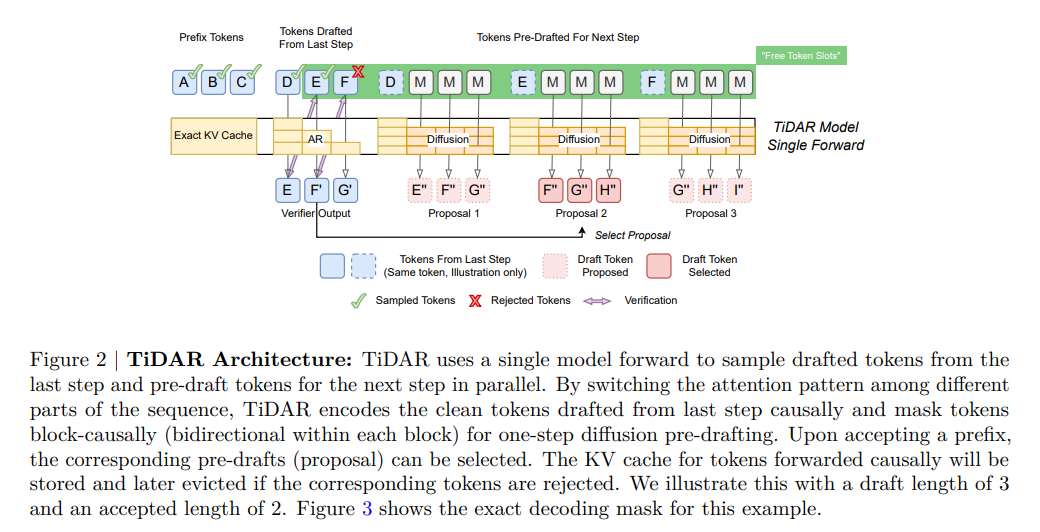

12月2日,科技媒体Tom'sHardware报道了英伟达最新论文中介绍的TiDAR新型AI解码方法。TiDAR结合了自回归和扩散模型机制,通过利用GPU的“空闲槽位”加速文本生成。自回归模型按顺序生成文本,而扩散模型则一次性生成多个可能的词。TiDAR的核心在于在不牺牲质量的前提下,通过单步生成多个Token来提升响应速度并降低GPU运行时长。

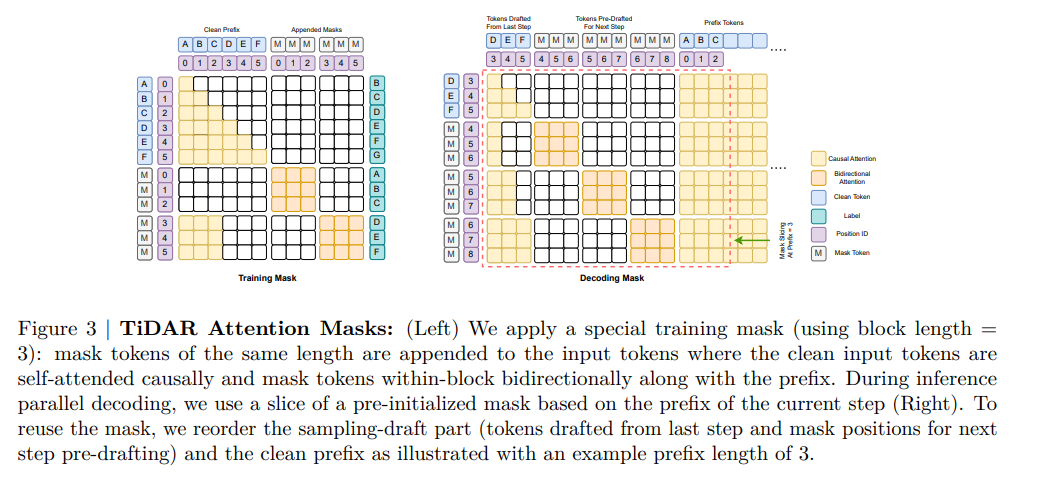

TiDAR技术原理上创新性地训练单个Transformer模型同时执行自回归“下一词预测”和基于扩散的“并行起草”。它通过结构化的注意力掩码将输入分为三个区域:前缀区、验证区和起草区。这种设计让模型在利用扩散头并行起草新Token的同时,还能通过自回归头验证这些草稿,确保了KV缓存的结构有效性。

研究团队基于Qwen系列模型进行了测试。在HumanEval和GSM8K等基准测试中,TiDAR的准确率与基准模型持平甚至略有提升。在速度方面,15亿参数版本的TiDAR模型实现了4.71倍的吞吐量增长;而80亿参数版本的表现更为抢眼,吞吐量达到了Qwen3-8B基准的5.91倍。这表明TiDAR能有效利用GPU的显存带宽,在不增加额外显存搬运的情况下生成更多Token。尽管实验数据亮眼,TiDAR目前仍面临规模扩展的挑战,未来将在更大规模的模型上进行验证。

相关内容

热门资讯

18万起!众擎T800人形机器...

12月2日,众擎公司正式发布了T800人形机器人,定价18万元起。这款机器人以其出色的动态表现和多功...

国内首个反垄断知识增强大模型亮...

12月2日,中国科学院大学在“他山青年创新论坛・Agent4S产学研峰会暨第十期中国科学院大学学科交...

大众PowerCo电池厂今年启...

12月2日,大众汽车下属电池子公司PowerCo宣布,其位于下萨克森州萨尔茨吉特市的电池工厂计划在今...

五月天南沙开唱在即!周边住宿指...

五月天【#5525回到那一天】25周年巡回演唱会广州站将于12月5日开始在南沙区举行。据悉,2025...

以下是一些改写“回应民生关切”...

回应民生关切是政府工作的重要使命。通过加强政策调研,精准把握民众需求,制定切实可行的举措。在教育方面...

英伟达TiDAR技术:AI文本...

12月2日,科技媒体Tom'sHardware报道了英伟达最新论文中介绍的TiDAR新型AI解码方法...

众擎T800人形机器人震撼亮相...

今日,众擎机器人发布了众擎T800人形机器人的实拍视频,展示了其在空中回旋踢和连续多次回旋踢的能力,...

华为问界M9海外版亮相:支持卫...

今日,博主@爱叨叨的Steven分享了海外版问界M9汽车的车机界面,透露车机已完成海外化,包括地图、...

以下是一些改写“回应民生关切”...

回应民生关切是政府工作的重要使命。通过加强政策调研,精准把握民众需求,制定切实可行的举措。在教育方面...

福特C-Max混动车致命故障致...

近日,亚利桑那州发生一起针对福特汽车及其经销商的重大诉讼。60岁的驾驶员Abimael Felici...